GAE Cloud の datastore に upload する script を作成

参考ファイルはこちら guestbook.py

今回程度のレコードサイズのデータの場合、read は 150 レコード、 put (write)は 20~30レコード程度毎の処理としました。利用方法

- まず、spreadsheet のデータを読み込みます。

- 今回は対象は DOW の株価データで 960 レコード程度です。

- SDK 環境では一度にすべての spreadsheet のデータを読み込むことができましたが、

cloud では 100 行程度 ( 200行はエラー ) ごとに複数のシートにデータを分割 - "read" とし、シートの key と シート番号を指定

- 1 sheet 分のデータを Memcache に読み込みます。

- 今回は対象は DOW の株価データで 960 レコード程度です。

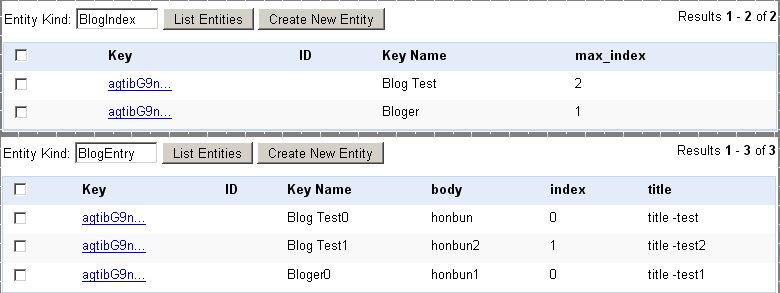

- 読み込んだデータを GAE Cloud の datastore に書き込みます。

- "put" を指定

- 100 行一度に書き込もうとするとエラーになりますので、今回の場合、20行程度ごとに

区切り、 offset をかけながら、何度かに分けて書き込み処理を行ないました。

- "put" を指定

- offset は自動的に加算するようにしましたので、[Sign Guest]を繰り返しクリック

- 1 sheet 分のデータの upload が完了したら Memcache をクリア

- 次のシート番号を指定し、同様の作業を繰り返します。